- 2025-02-05

- 43 بازدید

- 0 دیدگاه

- هوش مصنوعی

گوگل تعهد خود به عدم توسعه سلاحهای هوش مصنوعی را لغو کرد

گوگل روز سهشنبه اصول هوش مصنوعی خود را بدون سر و صدا بهروزرسانی و برخی از اصول هوش مصنوعی خود که شامل تعهدات مربوط به عدم استفاده از این فناوری در روشهایی که «موجب آسیب کلی میشوند یا احتمال آسیب کلی دارند» را حذف کرد. بر این اساس غول جستوجوگر گوگل با تکیه بر آنچه که آن را «چشمانداز پیچیده ژئوپلیتیک» نامیده تعهد خود به عدم توسعه سلاحهای هوش مصنوعی را کنار گذاشته است.

بر اساس گزارش منتشر شده، بخشی از دستورالعملهای اخلاقی هوش مصنوعی که قبلاً وجود داشت، گوگل را متعهد میکرد تا از طراحی یا استقرار هوش مصنوعی برای استفاده در نظارت، سلاحها و فناوریهایی که هدف آنها آسیب رساندن به افراد است، خودداری کند. این تغییر ابتدا توسط واشنگتن پست مشاهده و سپس توسط آرشیو اینترنت ثبت شد.

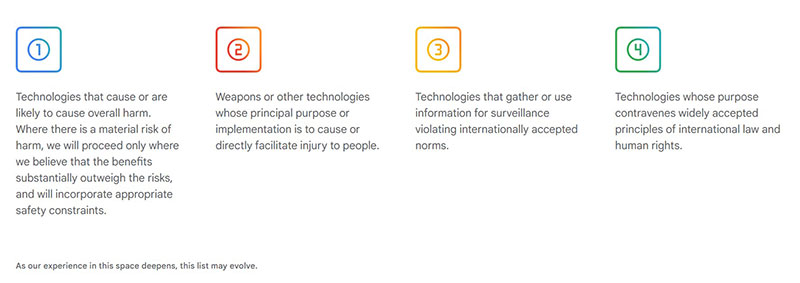

اصول هوش مصنوعی گوگل پیش از تغییر

اصول هوش مصنوعی گوگل پیش از تغییر

همزمان با این تغییرات، دمیس هاسابیس، مدیرعامل گوگل دیپمایند، و جیمز مانیکا، مدیر ارشد فناوری و جامعه گوگل، پستی در وبلاگ گوگل منتشر کردند که در آن «اصول اصلی» جدیدی را که اصول هوش مصنوعی گوگل بر آنها متمرکز خواهد بود، تشریح کردند. این اصول شامل نوآوری، همکاری و توسعه «مسئولانه» هوش مصنوعی میشود، که مورد آخر هیچ تعهد مشخصی را شامل نمیشود.

در این پست وبلاگ آمده است: «رقابت جهانی برای رهبری در توسعه هوش مصنوعی در چشمانداز ژئوپلیتیک پیچیدهای در حال انجام است. ما معتقدیم که دموکراسیها باید با هدایت ارزشهای اصلی مانند آزادی، برابری و احترام به حقوق بشر، پیشرو در توسعه هوش مصنوعی باشند. همچنین معتقدیم که شرکتها، دولتها و سازمانهایی که این ارزشها را به اشتراک میگذارند، باید با همکاری یکدیگر هوش مصنوعی را ایجاد کنند که از مردم محافظت کند، رشد جهانی را تقویت کند و امنیت ملی را پشتیبانی کند.»

پیشینه تعهدات گوگل در استفاده نظامی از هوش مصنوعی

هاسابیس پس از خرید دیپمایند توسط گوگل در سال ۲۰۱۴ به این شرکت پیوست. او در مصاحبهای با Wired در سال ۲۰۱۵ گفت که این خرید شامل شرایطی بود که از استفاده فناوری دیپمایند در کاربردهای نظامی یا نظارتی جلوگیری میکرد.

اگرچه گوگل متعهد شده بود که سلاحهای هوش مصنوعی توسعه ندهد، اما این شرکت روی قراردادهای نظامی مختلفی کار کرده است، از جمله پروژه Maven که یک پروژه پنتاگون در سال ۲۰۱۸ بود که در آن گوگل از هوش مصنوعی برای کمک به تجزیه و تحلیل فیلمهای پهپاد استفاده کرد و قرارداد ابری نظامی Project Nimbus در سال ۲۰۲۱ با دولت اسرائیل.

این توافقنامهها، که مدتها قبل از پیشرفت هوش مصنوعی به شکل امروزی آن منعقد شده بودند،باعث ایجاد تنش در میان کارکنان گوگل شد که معتقد بودند این توافقنامهها اصول هوش مصنوعی شرکت را نقض میکنند.

بهروزرسانی دستورالعملهای اخلاقی گوگل در مورد هوش مصنوعی، این شرکت را بیشتر با توسعهدهندگان رقیب همسو میکند. فناوری Llama متا و ChatGPT اوپنایآی برای برخی موارد استفاده نظامی مجاز هستند و توافقی بین آمازون و سازنده نرمافزار دولتی Palantir، شرکت Anthropic را قادر میسازد تا هوش مصنوعی Claude خود را به مشتریان نظامی و اطلاعاتی ایالات متحده بفروشد.

این تغییرات نشان میدهد که گوگل در حال تطبیق خود با واقعیتهای جدید در فضای رقابتی و ژئوپلیتیک است، اما این موضوع نگرانیهایی را در مورد پیامدهای اخلاقی و انسانی استفاده از هوش مصنوعی در زمینههای نظامی و نظارتی ایجاد میکند.

ارسال دیدگاه