- 2025-01-31

- 81 بازدید

- 0 دیدگاه

- هوش مصنوعی

مایکروسافت مدل DeepSeek R1 را به رایانههای شخصی کوپایلت پلاس میآورد

هوش مصنوعی DeepSeek با سرعت چشمگیری در حال فراگیر شدن در دنیای موبایل است و اکنون با حمایت کامل مایکروسافت، به طرز شگفت انگیزی در حال گسترش به دنیای ویندوز است.

مایکروسافت مدل DeepSeek R1 را به کوپایلت ویندوز میآورد

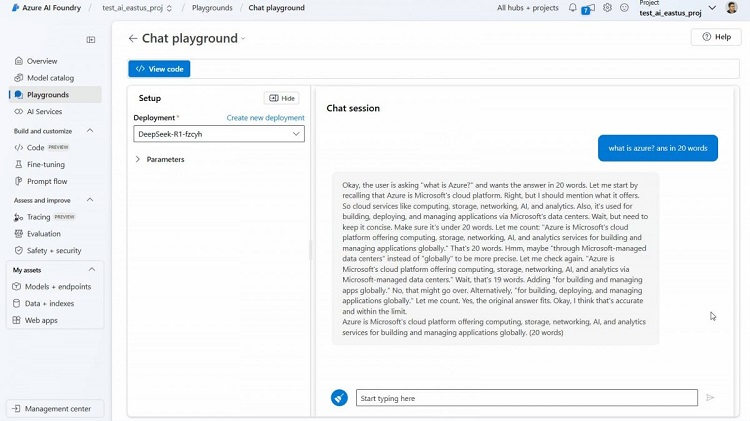

این غول دنیای نرمافزار، مدل DeepSeek R1 را به پلتفرم Azure AI Foundry خود اضافه کرده است تا توسعهدهندگان بتوانند برنامهها و خدمات مبتنی بر فضای ابری را با استفاده از آن آزمایش و ایجاد کنند. امروز، مایکروسافت اعلام کرد که نسخههای بهینهشده R1 را به رایانههای شخصی Copilot پلاس خواهد آورد.

این مدلهای بهینهشده ابتدا برای دستگاههای مجهز به تراشههای اسنپدراگون ایکس، دستگاههای دارای پردازندههای Intel Core Ultra 200V و سپس رایانههای شخصی مبتنی بر AMD Ryzen AI 9 در دسترس خواهند بود.

نخستین مدل، DeepSeek-R1-Distill-Qwen-1.5B خواهد بود که یک مدل 1.5 میلیارد پارامتری است و مدلهای بزرگتر و قدرتمندتر 7B و 14B نیز به زودی در دسترس قرار خواهند گرفت. این مدلها از طریق Microsoft AI Toolkit برای دانلود قابل دسترس خواهند بود.

مایکروسافت با OpenAI (سازنده ChatGPT و GPT-4o) همکاری بسیار نزدیک و سرمایهگذاری دوجانه دارد، اما به نظر میرسد که در این میان، جانب هیچکس را نمیگیرد و پلتفرم Azure آن میزبان مدلهای GPT (متعلق به OpenAI)، Llama (متعلق به Meta)، Mistral (متعلق به یک شرکت هوش مصنوعی) و اکنون دیپ سیک است.

اگر به هوش مصنوعی لوکال علاقه دارید، ابتدا AI Toolkit را برای VS Code دانلود کنید به عنوان نمونه “deepseek_r1_1_5” مدل 1.5B است. سپس روی Try in Playground بزنید و ببینید که این نسخه بهینه R1 چقدر هوشمند است.

بهینهسازی مدل، که گاهی اوقات “knowledge distillation” نیز گفته میشود، فرآیند اخذ یک مدل هوش مصنوعی بزرگ (DeepSeek R1 کامل 671 میلیارد پارامتر دارد) و انتقال هرچه بیشتر دانش آن به یک مدل کوچکتر (به عنوان نمونه 1.5 میلیارد پارامتر) است.

این یک فرآیند بینقص نیست و مدل بهینه شده در مقایسه با مدل کامل توانایی کمتری دارد، اما اندازه کوچکتر به آن امکان میدهد مستقیماً روی سختافزار مصرفکننده (به جای سختافزار ویژه هوش مصنوعی که دهها هزار دلار هزینه دارد) اجرا شود.

ارسال دیدگاه